| GRU |

| 作者:徐迅 发表时间:2023-06-26 阅读次数:644 |

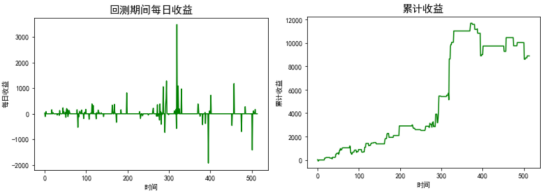

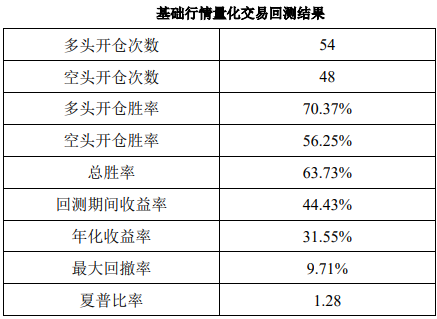

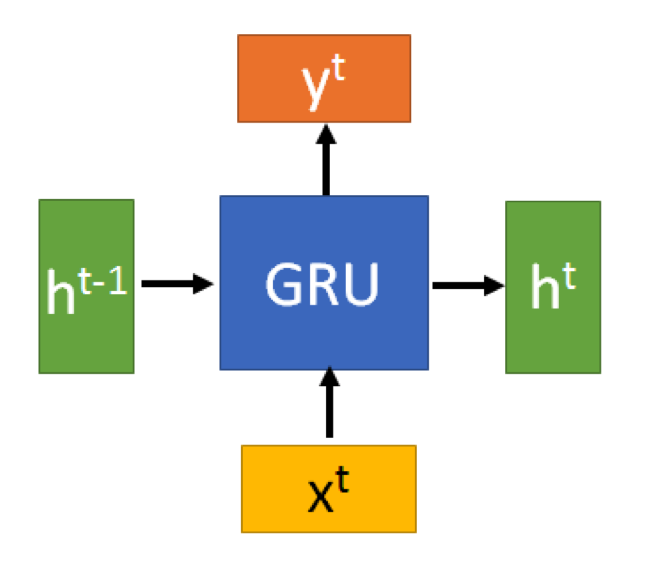

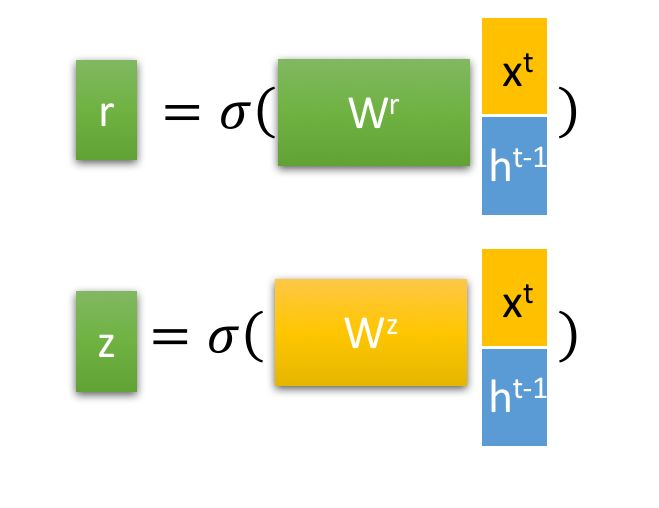

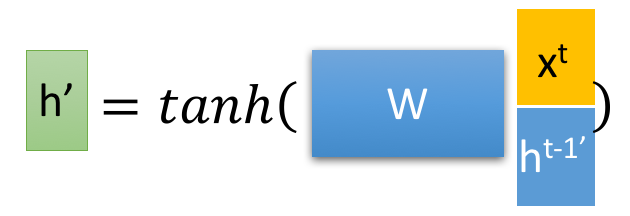

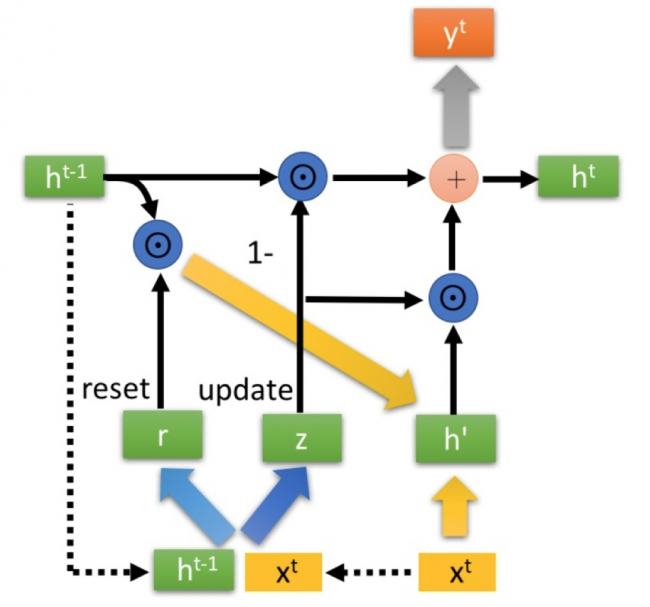

| 1.GRU简介 GRU(Gate Recurrent Unit)是循环神经网络(Recurrent Neural Network, RNN)的一种。和LSTM(Long-Short Term Memory)一样,也是为了解决长期记忆和反向传播中的梯度等问题而提出来的。GRU和LSTM在很多情况下实际表现上相差无几,但是GRU相比LSTM更容易计算。 2.GRU 2.1GRU的输入输出结构 GRU的输入输出结构与普通的RNN是一样的。 有一个当前的输入x^t,和上一个节点传递下来的隐状态h^(t-1),这个隐状态包含了之前节点的相关信息。 结合和x^t和h^(t-1),GRU会得到当前隐藏节点的输出y^t和传递给下一个节点的隐状态h^t。  2.2GRU的内部结构 首先,我们先通过上一个传输下来的状态h^t-1和当前节点的输入x^t来获取两个门控状态。如下图2-2所示,其中r控制重置的门控(reset gate), z为控制更新的门控(update gate)。  得到门控信号之后,首先使用重置门控来得到“重置”之后的数据,h^(t-1)=h^(t-1)⊙r再将h^(t-1) 与输入x^t进行拼接,再通过一个tanh激活函数来将数据放缩到-1~1的范围内。即得到如下图2-3所示的h'。  这里的h'主要是包含了当前输入的数据x^t。有针对性地对h^t添加到当前的隐藏状态,相当于“记忆了当前时刻的状态”。类似于LSTM的选择记忆阶段。  最后介绍GRU最关键的一个步骤,我们可以称之为“更新记忆”阶段。 在这个阶段,我们同时进行了遗忘了记忆两个步骤。我们使用了先前得到的更新门控。 更新表达式:h^t=(1-z)⊙h^(t-1)+z⊙h' 门控信号Z的范围是零到一,信号值越接近一,代表网络记忆下来的数据越多,该数据对训练结果的影响也越大。GRU的门控单元相比LSTM较少,这时因为GRU使用同一个门控单元Z同时进行选择和遗忘记忆。 3.量化案例 GRU模型输入变量为开盘价减日内最高价,开盘价减日内最低价,开盘价 减收盘价和成交量,输入维度为4。训练数据为2013年11月20日至2018年12月10日的沪银期货交易数据。通过 GRU 神经网络模型对沪银期货第N+1 天开盘价相对于第 N 天收盘价的涨跌概率情况进行预测,并以此构建交易策略如下: 当预测涨跌概率大于 65%且小于 80%时,在第 N 天收盘时多头开仓,并且在第N+1 天开盘时平仓; 当预测涨跌概率大于 20%且小于 35%时,在第 N 天收盘时空头开仓,并且在第N+1 天开盘时平仓。 选择日期从 2018 年 12 月 11 日到 2021 年 1 月 20 日的上海商品期货交易所白银期货主力连续合约的相关数据进行量化交易回测。首先通过选择优化后的模型预测下一天的涨跌概率,验证集预测天数共 514 天。通过模型预测涨跌概率结果根据量化投资策略来进行量化交易回测。

回测结果如表,策略总胜率为63.73%,年化收益率为31.55%,最大回测9.71%,夏普比为1.28。 参考文献:[1]崔梦颖. 基于GRU神经网络的沪银期货量化投资策略[D].华中科技大学,2021.DOI:10.27157/d.cnki.ghzku.2021.002598. |